-

Postów

18978 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

681

Treść opublikowana przez MaxPan

-

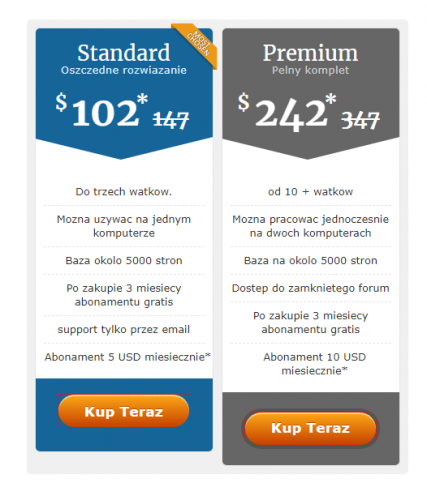

Od 29.11.2019 godzina 00.01 po 30.11.2019 godzina 23.59. Obniżono cenę Xneolinks Standard i Xneolinks premium o 30%.

- 2669 odpowiedzi

-

- xneolinks

- trust linki

-

(i 3 więcej)

Oznaczone tagami:

-

Ja używam Xevil Beta ( z Recaptcha2) + 2captcha. Xevile stoją na dedykach i na nich wysyłam captcha z Xneolinksów. 1 Xevil na mocnym serwerze potrafi obsłużyć bardzo wiele Xneolinksów. Testowałem nawet 20 szt Xneolinksów na 15 watkach każdy - 1 Xevil na 100 watkach Recaptcha2 i działało.

- 2669 odpowiedzi

-

- 1

-

-

- xneolinks

- trust linki

-

(i 3 więcej)

Oznaczone tagami:

-

Do 30.11 jest promocja na Xrumer+Xevil - 30%. Wychodzi 170 USD za wersje standard ( rożni się od PRO wyłącznie ilością jednobocznie uruchomionych kopii standard 2, pro 5). Żeby otrzymać dostęp do Xevil BETA ( tylko ta wersje rozwiązuje Recaptcha2) należy po prostu przedłużyć abonament Xrumer na poł-roku( 60 USD) i napisać do Botmastera. Jak kupować Xrumer 1.Rejestrujemy konto na https://xrumer.pl ( mój ref) lub czysty link www.botmasterlabs.net 2. Zalogować się 3. Prawy górny róg przycisk "BUY PRODUCT" 4.Jeśli chcemy kupić przez PayPal klikamy logo PayPal i na dole otwiera sie okienko formy kontaktowej, wysyłamy zgłoszenie i na email otrzymamy za jakiś czas list ot Botmastera z opisem jak dokonać platnosci. 5. Można dodatkowo powiadomić BM ,że chcecie BETA Xevil on powiem jak przedłużyć abonament.

-

Ale k2 w 99% to profil (Wyglądający jak artykuł), więc używając opcji "od wcześniej zarejestrowanego po prostu moderujesz profil wstawiając nowy link kasując stary, robisz rotacyjny swl . Chyba, że tworzysz wpisy na blogu k2 wtedy można i z jednego konta ale takich miejscówek jest bardzo malo. Proxy używa się, żeby nie wywaliły z hostingu przyjdzie abuse. Wywalą z hostingu i nie oddadzą nawet plików tak zazwyczaj kończy się linkowanie bez proxy na serwerach bez foolproof. Kwestie rankowania linków k2 pomijam.

- 2669 odpowiedzi

-

- 1

-

-

- xneolinks

- trust linki

-

(i 3 więcej)

Oznaczone tagami:

-

@kamilp7 na CORE DA 2 GB SSD ???

-

Filn instruktażowy: Harwest wewnetrzny strony www przy pomocy HTML::LinkExtractor W tym filmiku pokazano hak przy pomocy a-parser harwestować i analizować stronę www. W filmie pokazano: Harwest strony (уpoziomy) przy pomocy strony wyników "Harwestować do poziomu" Otrzymanie title (usunięciem niepotrzebnego kodu html) Otrzymanie takich parametrów: ilość przekierowań kod odpowiedzi serwera ilość wychodzących linków Przydatne linki: Zostawiajcie komentarze Subskrybujcie kanal YouTube! Wstępujcie w grupę Telegram:

-

Jeśli to standardowe makrosy dołączone do Xneolinks to logi wyłącznie te co znajdują się obok raportów. Tam 3 pliki : raport, logi: niedane bez opisów, Logi:nieudane z opisami. Innych logów nie ma. Natomiast na własnych szablonach można włączyć logi bardziej dokładne a nawet zdjęcia (przeglądarki) na kolejnych etapach pracy makrosa. Ogólnie logi lub niepełne raporty jeśli ich nie usuwać mogą zajmować nawet 50 GB po parę tygodniach linkowania. Dla tego trzeba ich usuwać jeśli włączyłeś ich zapisywanie. Mogą

- 2669 odpowiedzi

-

- xneolinks

- trust linki

-

(i 3 więcej)

Oznaczone tagami:

-

Tak, jeśli będą jakieś kody napisze na PIO,

-

Bootmaster nie anonsuje takie rzeczy bo wszyscy by czekali na promocję i było by zero sprzedaży w okresie po za promocją.

-

Usprawnienia В SE::Google::ByImage dodano nowe algorytmy pracy z recaptcha, inne zmiany В SE::Yandex Dodano możłiwośc jednoczesnej pracy z OCR programowym i on-line( typu anticaptcha) В Rank::AhrefsDodano możliwosć wyboru domen Całkowie przepisany SE::Yandex::SQI, Zmieniono zbieranie danych Zrealizowano odbanowanie proxy w [PLAIN]SE::DuckDuckGo::Images[/PLAIN]В Net::Whois Dodano zbieranie dat wygaśnięcia domen Optymalizowano pracę z proxy przy dużej ilości wątków Usprawniono finckje Bypass Cloudflare Dodano tools.aparser.version(), daje możliwość otrzymać dane o wersji A-Parser Dostosowanie a-parser do zmian w wyszukiwarkach W mobilnych wynikach SE::Google::Modern Usprawniono harwest wiadomości, również wyszukiwanie linków i anchorów w wynikach "stacjonarnych" В SE::Yandex Usprawniono definiowanie captcha , również wyszukiwanie linków w cash Usprawniono harwest cen i ilości komentarzy w Shop::AmazonUsprawniono prace [PLAIN]SE::DuckDuckGo::Images[/PLAIN] z zapytaniami zawierającymi więcej jak 1 słowo. GooglePlay::Apps, SE::YouTube, Rank::Ahrefs Zmiany Naprawiono funkcję unikalizacji proxy w Windows 10 Naprawiono błąd w Check::BackLinkNaprawiono błąd niewykorzystania Content-Type в Net::HTTPNaprawiono rzadki błąd z wyborem zapytań z plików Naprawiono opracowanie przekierowan na niestandardowych portach Naprawiono wyświetlenie wielopoziomowych danych в tools.CSVline JS parsery: naprawiono problem z interface przy braku wymagających Node.js modulow JS parsery: naprawiono błąd z podlącxzniem jimp

-

Napisz do tego człowieka jeśli ma czas wyszkoli https://www.forum.optymalizacja.com/profile/41410-~larry

-

również szybko wyleciałeś by z forum , więc gdzie logika w tym co piszesz? a jest czemu?

-

Idą finalne testy sytemu automatycznego odnowienia i restartowania licencji. Jeśli ktoś płaci abonament miesięcznie i abonament kończy się za parę dni polecam przedłużyć abonament wcześniej bo mogą być opóźnienia z zaksięgowaniem i opracowaniem płatności tak jak platnosci są przełączane do nowego panelu. Jeśli ktoś korzysta z programu ciągle przypominam, że w panelu klienta jest link gdzie automatycznie naliczony rabat 20% do platnosci rocznej.

- 2669 odpowiedzi

-

- xneolinks

- trust linki

-

(i 3 więcej)

Oznaczone tagami:

-

https://xneolinks.com/forums/docs/tools/menedzher-akkauntov-i-rabota-s-uzhe-sushhestvuyushhimi-akkauntami-v-xneolinks-r14/ Prawy przycisk myszki "Przetłumacz na język Polski"

- 2669 odpowiedzi

-

- xneolinks

- trust linki

-

(i 3 więcej)

Oznaczone tagami:

-

Na forum masz przykładowe, przeczytaj jak ich rozbudować innych wskazówek oprócz listy gotowych nie znam. Nie rozumiem pytania

- 2669 odpowiedzi

-

- xneolinks

- trust linki

-

(i 3 więcej)

Oznaczone tagami:

-

na dedyku za ok 20 USD może zrobić do 3k linków w 24h, na tanim VPS do 1000. Potrzebujesz więcej? Co do bazy, jeśli baza wystawiona dla wszystkich użytkowników to staje się bazą publiczną, a co za tym idzie nie polecam docelową z niej linkować. Baza publiczna Xneolinks to baza podglądowa, ona nawet podzielona na CMS, żeby każdy mógł zobaczyć gdzie i w jaki sposób Xneolinks może dodać link. Ta baza + przykładowe footprinty na forum to doskonała podstawa do zrobienia własnej listy.

- 2669 odpowiedzi

-

- xneolinks

- trust linki

-

(i 3 więcej)

Oznaczone tagami:

-

Tak na palcach nikt Tobie nic nie powie, trzeba paczyć logi i na miejscówki. Przyczyn może być 100 również te które Oxan_20 wymienił. Niektóre z nich Ban po IP Ban po email ( nawet domenie) Zmieniona tekstowa captcha Zmieniono coś w formie rejestracji, postingu OCR nie rozwiązał captcha za tyle prób ile ustalono w Xneolinbks i wiele, wiele innych....

- 2669 odpowiedzi

-

- xneolinks

- trust linki

-

(i 3 więcej)

Oznaczone tagami:

-

kwk9k jeszcze raz wkleisz czyjeś zaplecze na forum dam urlop.

-

@cannot Rozmawiałem z Kubą dzisiaj i zapytałem o to co Ty piszesz. Niestety to co opisałeś nie pokrywa się z tym co Kuba mi odpowiedział. Zorientowałeś się, że bazy nie ma po więcej 7 dniach od skasowania. Niestety oni trzymają kopie zapasowe do 7 dni wstecz.

- 118 odpowiedzi

-

- 1

-

-

- hosting za sms

- hosting sms

-

(i 4 więcej)

Oznaczone tagami:

-

Dokładnie, cannot czy Ty nie widzisz, że wy po prostu gadacie o tym samym ale w rożnych kontekstach. Ja podejrzewam, że support myśli, że to baza z wczoraj. Napisz, że potrzebujesz kopie bazy obojętnie z jakiego dnia Muszą mieć kopie bazy danych na wypadek uszkodzenia dysków na przykład.

- 118 odpowiedzi

-

- hosting za sms

- hosting sms

-

(i 4 więcej)

Oznaczone tagami:

-

Może Kuba Ciebie złe zrozumiał, i kopie bazy z poprzednich dni ma. Pytałeś go o to?

- 118 odpowiedzi

-

- hosting za sms

- hosting sms

-

(i 4 więcej)

Oznaczone tagami:

-

Tak jak napinano wcześnie proxy z autoryzacja login/haslo nie działają w Xevil. Zero/jedynkowa opcja. Nie może zostać wprowadzona bo to nie od Xevil zależy a od Chrome. Czytaj forum Botmastera tam wszytko to napisane z 20 razy.

-

Xeon E3-1245v2 (4c/8th) - 32GB DDR3 1333 MHz na takim 50 wątków Recaptcha2 chodzi obciążenie CPU ok 90-100%. Ram ok 60 %. Przy umowie, że masz szybkie proxy. A skąd ja mam wiedzieć co Tobie klienci będą wysyłać, same Recpatcha2 czy inne captcha. Nie da się odpowiedzieć na Twoje pytanie.

-

1. Rozwiązywać Recaptcha2 na jednym IP i pytać czemu tak wolno to jest dobre pytanie 2. Xevil na moich maszynach rozwiązuje recaptcha 2 w czasie ok 60-120 sek przy użyciu proxy, korzystam z dedyków OVH. Xevil działa na 50-70 wątkach. Ale czy to dotyczy Recaptcha2? Zazwyczaj jest o wiele dłużej.